Сайт готов к работе, запущен, но трафик «0». Его нет в результатах поиска Google. Скорее всего, эта проблема легко решается. Рассмотрим 4 причины, прочему сайта нет в выдаче и советы о том, как ускорить его индексацию.

Сайт не проиндексирован

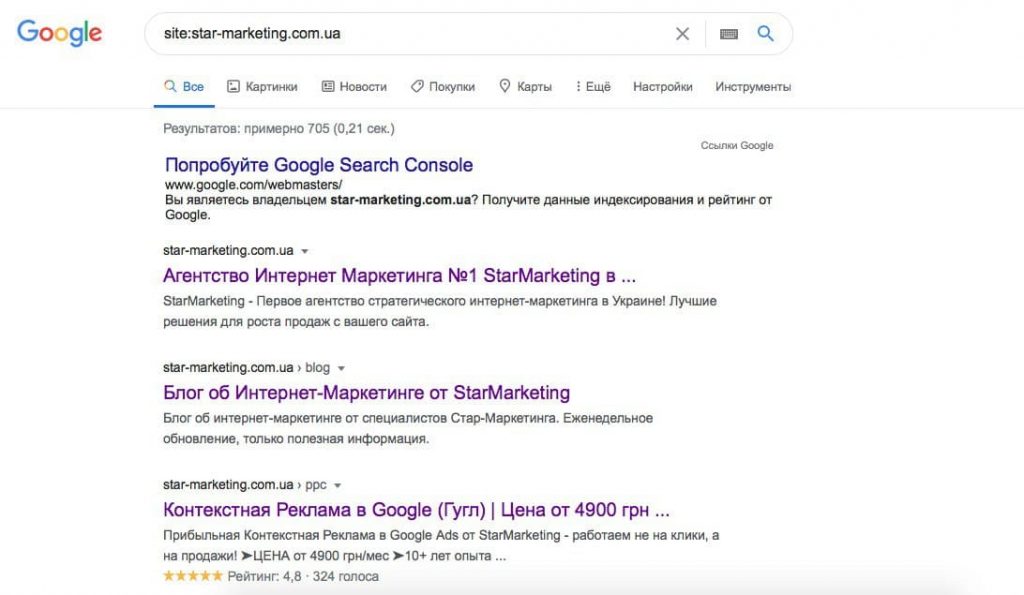

Поисковые роботы обнаруживают новый веб-ресурс, переходя по ссылкам и регистрируют его в базе данных. Узнайте, прошел ли ваш сайт индексацию, набрав в поиске «site:название сайта» без пробела после двоеточия. Например: site:star-marketing.com.ua. В результатах выдачи появятся все проиндексированные страницы сайта.

Сайт попадет в базу данных быстрее через сервис «Google Search Console». Зарегистрируйтесь, подтвердите права на сайт, отправьте запросы на индексацию нужных страниц. В панели веб-мастера отслеживайте уведомления об ошибках, рекомендации, состояние индексации, статистику переходов.

Для отправки страницы на индексацию вручную, введите адрес страницы в поле «Проверка URL».

Через время отправленная страница должна появиться в выдаче Google.

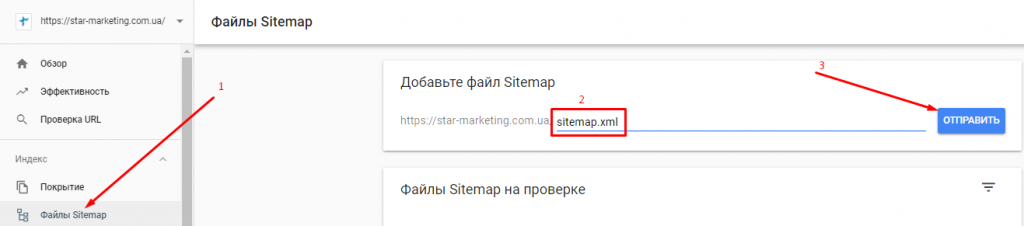

Алгоритмы быстрее просканируют онлайн-площадку по карте сайта для поисковых роботов. Добавляйте в карту сайта внутренние ссылки на каждую страницу, которую нужно проиндексировать. Не используйте линки, появляющиеся после действий пользователей (результаты поиска по сайту, фильтров и т.д.). Поисковые роботы не должны их индексировать. Карта сайта находится по адресу sitemap.xml. Например: https://star-marketing.com.ua/sitemap.xml. Отправьте ее в Google Search Console:

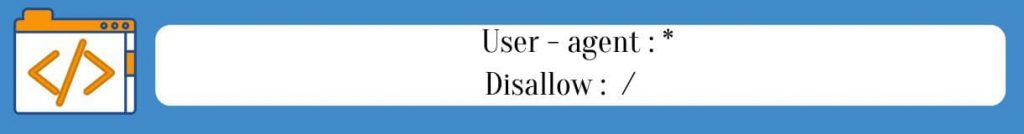

Запрет на индексацию в файле robots.txt

В корневой каталог разработчики добавляют файл robots.txt., регулирующий посещение веб-страниц роботами. Они закрыты для индексации, если в нем есть строки:

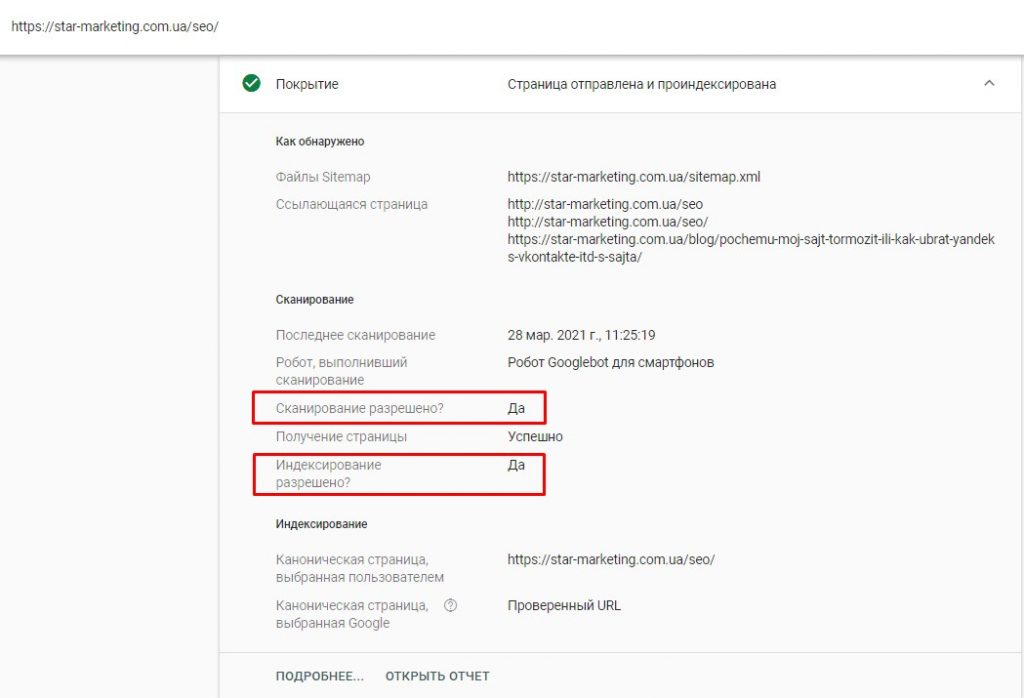

Когда работа над сайтом завершена, веб-мастер может забыть убрать запрет, и система его не увидит. Проверьте, активен ли запрет отслеживания: отправьте файл сайта в консоль поиска Google. Если алгоритмы просканировали его и нашли блокировку, в отчете «Проверка URL — Покрытие» ищите ошибку: «Submitted URL blocked by robots.txt».

Обнаружили его на своей платформе? Рекомендуем обратиться к профессионалам. Они корректно отключат запрет отслеживания. После устранения robots.txt подайте запрос на регистрацию в Google.

Когда сайт проиндексирован, в отчете «Проверка URL — Покрытие» появится соответствующая отметка и будет указано, что сканирование разрешено:

Блокировка индексации страницы на WordPress

Такой запрет делает страницы невидимыми для алгоритмов, что нужно в процессе верстки или тестирования. Они не появятся в выдаче, даже если отправить карту сайта в Google.

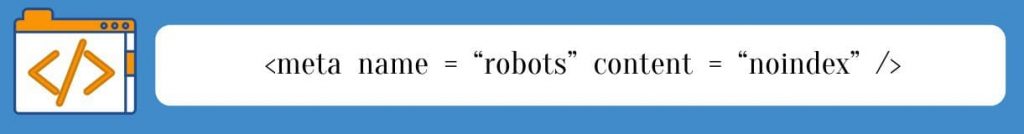

Код выглядит так:

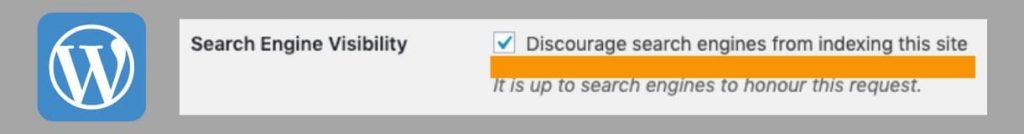

WordPress автоматически добавляет в HTML мета-тег «noindex», запрещающий индексацию, если в разделе «Search Engine Visibility» активирована эта опция:

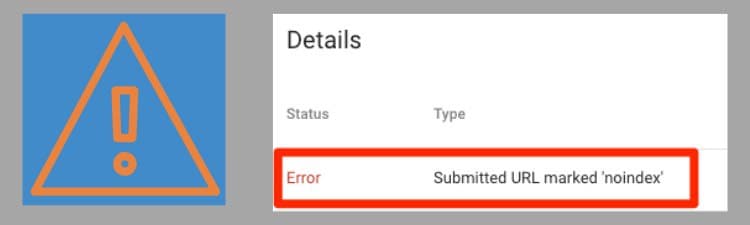

Галочку в этом блоке устанавливают во время разработки сайта, чтобы пользователи не заходили на него. Когда работы завершены, эту опцию часто забывают отключить. Узнайте, есть ли уведомление о запрете сканирования на странице с отчетом в консоли поиска в Google:

Санкции от Google

Это наименее вероятная причина того, почему сайта нет в выдаче. Если он соответствует требованиям системы и учитываются изменения алгоритмов, фильтры не накладываются. Подробнее о санкциях поисковых систем можно узнать в нашей статье. Доверяйте исправление таких проблем опытным веб-мастерам!

Улучшение сайта для индексации

Разрабатывая веб-ресурс, учитывайте требования Google и особенности работы алгоритмов. SEO оптимизация сайта помогает привести сайт в соответствии им. Требуется всесторонняя настройка параметров, влияющих на регистрацию в поисковой системе и ранжирование.

Рассмотрим несколько факторов, ускоряющих регистрацию онлайн-площадки:

- Язык веб-страниц. HTML индексируется лучше, чем Java или AJAX.

- Внешние ссылки. Если на ваш сайт ссылается авторитетный источник, Google найдет его быстрее.

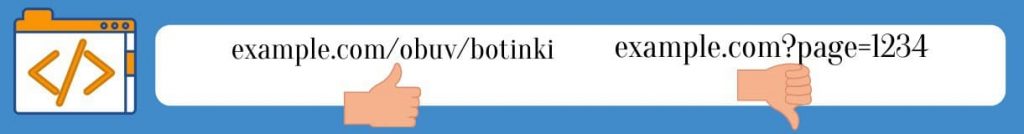

- Название страницы в пути URL (ЧПУ) алгоритмам найти легче, чем параметры URL:

- SEO-оптимизация – комплекс работ над сайтом для продвижения в ТОП. Веб-страницы, соответствующие поисковым запросам, хорошо ранжируются. Ключевые фразы в контенте, описании, URL показывают, что на веб-ресурсе есть информация, интересующая пользователей. Если они не используются, сайт не отобразится в выдаче по этим фразам.

- Страницы, идентичные по содержанию. Есть разные способы обнаружить дубли страниц. Один из них — Онлайн-сервис Ashrefs Site Audit. На обнаруженных дублях нужно указать каноническую страницу (основную) при помощи атрибута rel=»canonical», либо настроить переадресацию на нужную страницу (redirect 301).

- Неуникальный контент. Google не поддерживает плагиат. Публикуйте на сайте тексты с уникальностью не ниже 95 %. Добавляйте авторские изображения.

- Низкая скорость загрузки сайта. Это происходит, если используются «тяжелые» изображения и видео, сложная анимация, у веб-платформы и хостинга небольшой ресурс. Сожмите изображения, измените параметры кэширования и отключите лишние плагины. Это ускорит работу сайта. Если нужна более глубокая оптимизация скорости загрузки, обращайтесь к профессионалам.

Зачастую индексации нет, если в Google не отправлена карта сайта или в коде страницы есть блокировка в robots.txt. Эти неполадки легко устранить. Если наложены фильтры поисковой системы, обращайтесь за устранением проблемы к специалистам, чтобы не усугубить ситуацию ошибочными действиями. Работа над качеством сайта ускоряет индексацию и содействует быстрому продвижению в ТОП.