Сайт готовий до роботи, запущено, але трафік «0». Його немає у результатах пошуку Google. Швидше за все, ця проблема легко вирішується. Розглянемо 4 причини, чому сайту немає у видачі та поради про те, як прискорити його індексацію.

Сайт не проіндексований

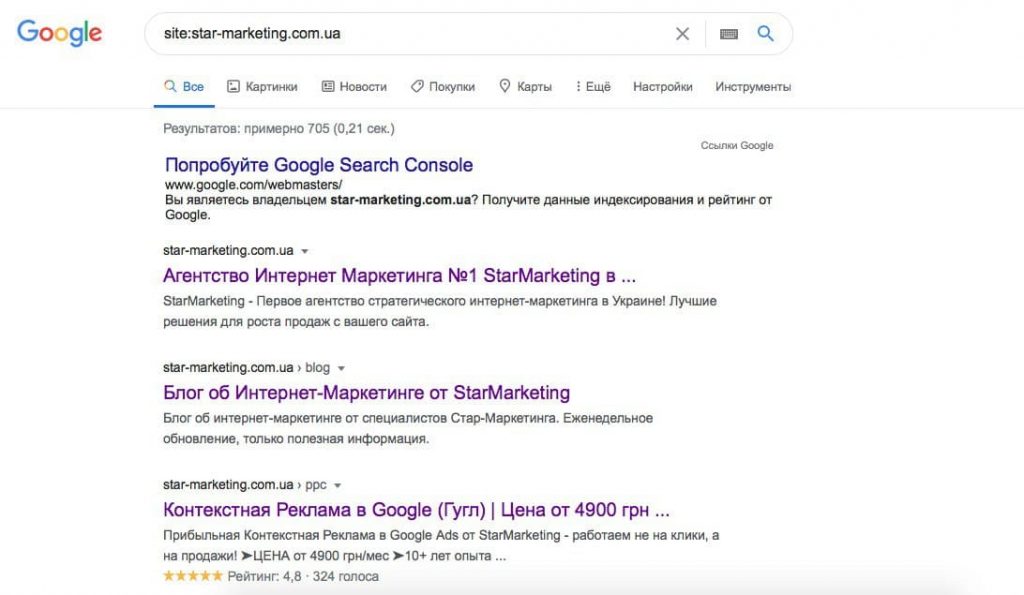

Пошукові роботи виявляють новий веб-ресурс, переходячи за посиланнями та реєструючи його в базі даних. Дізнайтеся, чи ваш сайт пройшов індексацію, набравши в пошуку «site:назва сайту» без пробілу після двокрапки. Наприклад: site:star-marketing.com.ua. У результатах видачі з'являться усі проіндексовані сторінки сайту.

Сайт потрапить у базу даних швидше через сервіс «Google Search Console». Зареєструйтесь, підтвердіть права на сайт, надішліть запити на індексацію потрібних сторінок. На панелі веб-майстра відстежуйте повідомлення про помилки, рекомендації, стан індексації, статистику переходів.

Щоб надіслати сторінку на індексацію вручну, введіть адресу сторінки в полі «Перевірка URL».

Через деякий час відправлена сторінка повинна з'явитися у видачі Google.

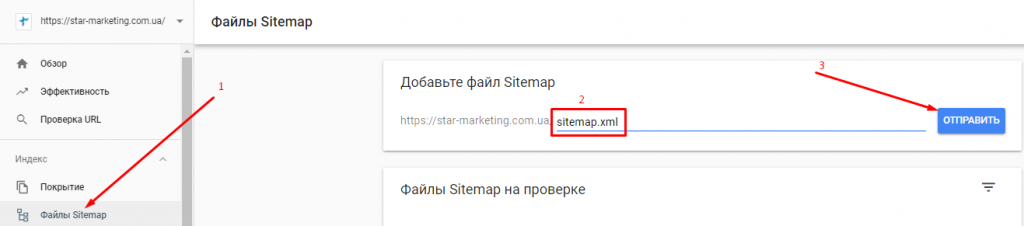

Алгоритми швидше просканують онлайн-майданчик картою сайту для пошукових роботів. Додайте до карти сайту внутрішні посилання на кожну сторінку, яку потрібно проіндексувати. Не використовуйте лінки, що з'являються після дій користувачів (результати пошуку сайту, фільтрів тощо). Пошукові роботи не повинні їх індексувати. Мапа сайту знаходиться за адресою sitemap.xml. Наприклад: https://star-marketing.com.ua/sitemap.xml. Надішліть її до Google Search Console:

Заборона на індексацію у файлі robots.txt

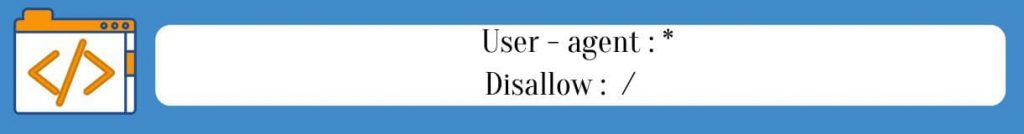

У кореневий каталог розробники додають файл robots.txt., який регулює відвідування веб-сторінок роботами. Вони закриті для індексації, якщо в ньому є рядки:

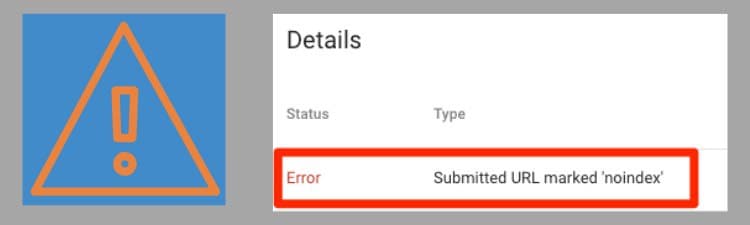

Коли роботу над сайтом завершено, веб-майстер може забути прибрати заборону, і система її не побачить. Перевірте, чи активна заборона відстеження: надішліть файл сайту в консоль пошуку Google. Якщо алгоритми просканували його та знайшли блокування, у звіті «Перевірка URL — Покриття» шукайте помилку: «Submitted URL blocked by robots.txt».

Виявили його на своїй платформі? Рекомендуємо звернутися до професіоналів. Вони коректно відключать заборону відстеження. Після усунення robots.txt надішліть запит на реєстрацію в Google.

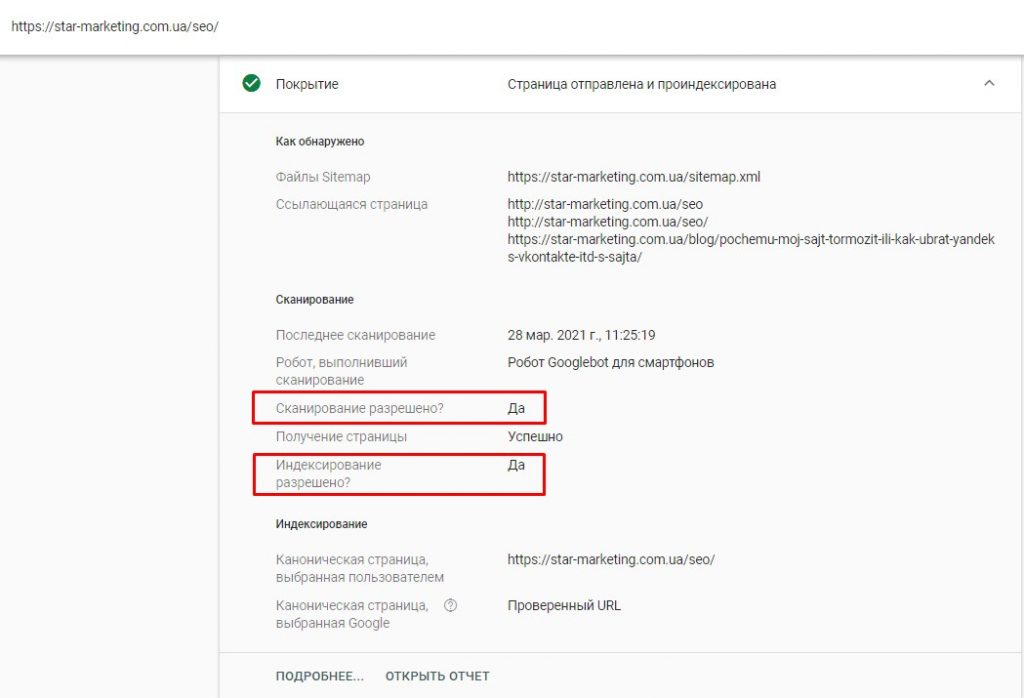

Коли сайт проіндексовано, у звіті «Перевірка URL — Покриття» з'явиться відповідна позначка та буде вказано, що сканування дозволено:

Блокування індексації сторінки на WordPress

Така заборона робить сторінки невидимими для алгоритмів, які потрібні в процесі верстки або тестування. Вони не з'являться у видачі, навіть якщо надіслати карту сайту до Google.

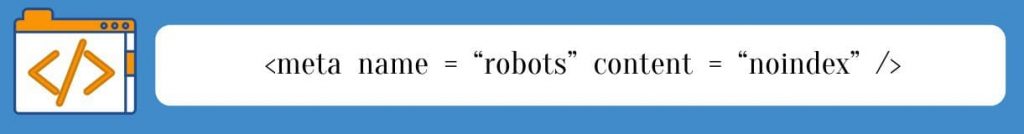

Код виглядає так:

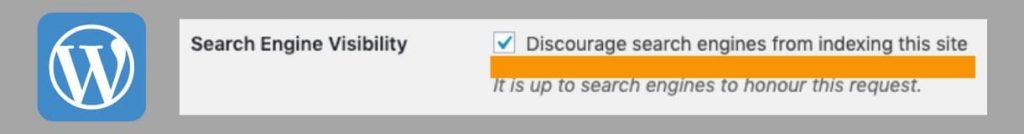

WordPress автоматично додає в HTML мета-тег "noindex", що забороняє індексацію, якщо в розділі "Search Engine Visibility" активована ця опція:

Галочку в цьому блоці встановлюють під час створення сайту, щоб користувачі не заходили на нього. Коли роботи завершено, цю опцію часто забувають відключити. Дізнайтеся, чи є повідомлення про заборону сканування на сторінці зі звітом у консолі пошуку в Google:

Санкції від Google

Це найменш ймовірна причина того, чому сайту немає у видачі. Якщо він відповідає вимогам системи та враховуються зміни алгоритмів, фільтри не накладаються. Докладніше про санкції пошукових систем можна дізнатися у нашій статті. Довіряйте виправлення таких проблем досвідченим веб-майстрам!

Покращення сайту для індексації

Розробляючи веб-ресурс, враховуйте вимоги Google та особливості роботи алгоритмів. SEO оптимізація сайту допомагає привести сайт відповідно до них. Потрібне всебічне налаштування параметрів, що впливають на реєстрацію в пошуковій системі та ранжування.

Розглянемо кілька факторів, що прискорюють реєстрацію онлайн-майданчика:

- Мова веб-сторінок. HTML індексується краще, ніж Java чи AJAX.

- Зовнішні посилання. Якщо на ваш сайт посилається авторитетне джерело, Google знайде його швидше.

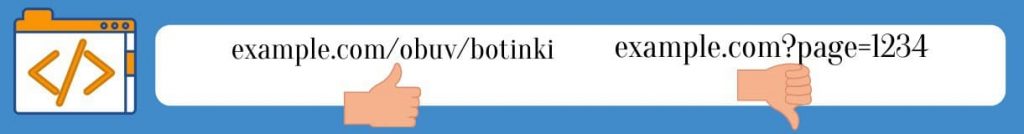

- Назва сторінки в дорозі URL (ЧПУ) алгоритмам знайти легше, ніж параметри URL:

- SEO-оптимізація – комплекс робіт над сайтом для просування у ТОП. Веб-сторінки, які відповідають пошуковим запитам, добре ранжуються. Ключові фрази в контенті, описі URL показують, що на веб-ресурсі є інформація, що цікавить користувачів. Якщо вони не використовуються, сайт не відобразиться у видачі цих фраз.

- Сторінки, ідентичні за змістом. Існують різні способи виявити дублі сторінок. Один з них – Онлайн-сервіс Ashrefs Site Audit. На виявлених дублях потрібно вказати канонічну сторінку (основну) за допомогою атрибуту rel = canonical, або налаштувати переадресацію на потрібну сторінку (redirect 301).

- Неповторний контент. Google не підтримує плагіат. Публікуйте на сайті тексти з унікальністю не нижче 95 %. Додайте авторські зображення.

- Низька швидкість завантаження сайту. Це відбувається, якщо використовуються "важкі" зображення та відео, складна анімація, у веб-платформи та хостингу невеликий ресурс. Стисніть зображення, змініть параметри кешування та вимкніть зайві плагіни. Це пришвидшить роботу сайту. Якщо потрібна глибша оптимізація швидкості завантаження, зверніться до професіоналів.

Найчастіше індексації немає, якщо Google не відправлена карта сайту або в коді сторінки є блокування в robots.txt. Ці проблеми легко усунути. Якщо накладено фільтри пошукової системи, звертайтеся за усуненням проблеми до фахівців, щоб не погіршити ситуацію помилковими діями. Робота над якістю сайту прискорює індексацію та сприяє швидкому просуванню у ТОП.